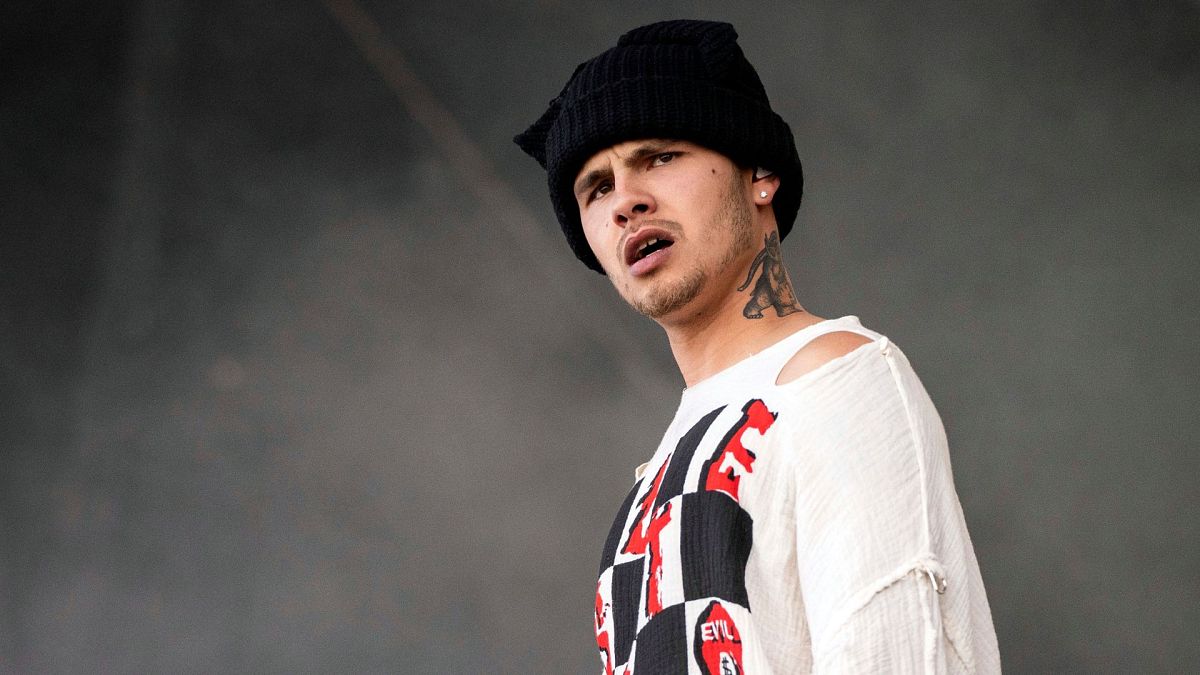

Meredith Whittaker 是非營利性Signal 基金會的總裁,該基金會負責運營加密的Signal 通訊應用程序,她是人工智能(AI) 領域的早期思想家之一,曾於2006 年為Google 領導了一個該技術的研究小組。

她因谷歌對性騷擾的態度而組織了一場罷工,並於 2019 年被迫離開公司。

隨後,她與他人共同創立了 AI Now Institute,並擔任美國聯邦貿易委員會顧問,但她仍然對大型科技公司及其在人工智慧新時代如何控制我們的數據抱有擔憂。

她接受《歐洲新聞下一步》採訪時談到歐洲的人工智慧和監管在今年的網路高峰會在里斯本。

歐洲新聞下一步:您已經談到了很多關於人工智慧以及我們正在經歷的人工智慧炒作的恐懼。您特別關心的是什麼?

梅雷迪思·惠特克(Meredith Whittaker):我認為我的擔憂不是技術本身,而是由少數大公司開發和控制的事實,這些大公司的利益當然是公司的利益、利潤、成長以及取悅人們。不一定是社會公益。

他們正在銷售、正在授權、正在創建、正在部署的人工智慧需要大量的數據,需要大量的運算能力,並有效地加強和擴展監控業務模式,這是在當談到不負責任的技術時,世界上大多數人都擔心這些危害的核心。

我認為我的恐懼和擔憂更多的是關於塑造人工智慧的人、機構和激勵措施,而不是科技本身,或者它可能以某種方式變得有知覺或像上帝一樣的想法。

我們來談談人工智慧的治理和監管。監理力道是否足夠?更具體地說,隨著歐洲準備自己的人工智慧指令,歐洲的表現如何?

[歐洲]人工智慧法案尚未完成。我們不太知道最終的形式是什麼。我認為我們需要暫時擱置判決。我認為歐洲已經做了很多事情,可以用來有力地檢查人工智慧的一些危害。

我想舉的一個例子是 GDPR 得到了嚴格的解釋和執行。嚴格可以很容易地用來禁止監控廣告,並且禁止監控廣告將對推動這些公司的激勵產生巨大且相當徹底的重組影響。

這意味著突然之間,用於創建人口統計資料的大量資料出售給廣告商、微觀目標、針對不同類型的人將不再被允許。

這當然會影響人工智慧,因為我們在社群媒體上發布的所有數據、我們的位置數據、我們的社交圖譜,所有這些數據來源都會突然變得不那麼有用。

嚴格來說,也許是不允許這些中心化公司收集和維護的。所以,這就是歐洲已經在這問題上採取立場的一個例子。問題其實是政治意願。

讓我們深入探討政治意願,您是否覺得在美國可能更是如此,有這樣的想法:讓我們在這方面更有企業化,讓我們賺取更多利潤?

嗯,當然。這些公司中有很多都位於美國。這是他們的管轄權,美國很清楚這一點。正是這些公司與美國政府合作。

他們通常為政府提供基礎設施。美國的政治局勢非常混亂,已經 20 年、30 年了,這取決於你在哪裡計算,而且我們沒有聯邦隱私法。

確實給我希望的一件事是,以客製化的方式為每個司法管轄區建立這些大規模的全球系統是非常困難的。

來自歐洲或另一個大市場的如此強大的監管對這些公司產生了塑造作用,即使它不是來自它們所在的司法管轄區。

收集資料的人工智慧「血汗工廠」會有多大危險?

我認為那裡的問題確實是勞工問題。最近估計有 1 億人處於非常不穩定的職位,他們實際上是人類管家,提供人工智慧和人工智慧公司所信賴的人類智慧。

這就是數據標籤。這就是資料管理,也就是校準。告訴系統什麼是可接受的,什麼是不可接受的。這就是內容審核;這就是對這些人工智慧系統在行為異常時產生的問題進行錯誤控制和管理。

這是一個龐大的數字。

我認為這項工作的品質確實存在問題。這項工作對人們心理健康造成的危害確實存在問題。這沒有爭議。

重複觀看或面對恐怖圖像或文字的工作對人們的心理健康有明顯的有害影響。我們得到了一些人的證詞,他們因為這種情況的令人不安而失去了工作、失去了人際關係、失去了生存的能力。

我認為有一個更大的問題,我們需要退一步,如果這些系統需要造成如此規模的損害(它們確實如此),那麼沒有其他方法可以使這些系統正常工作並讓它們為商業和大眾使用所接受。

我們對此感到滿意嗎?

您是否認為隨著越來越多的人使用生成式人工智慧軟體(例如 Chat GPT),隱私將成為更嚴重的受害者?

長期以來,隱私一直是科技商業模式道路上的犧牲品。

Signal 將繼續提供一個真正的私人安全港,遠離定義行業其他部分的大量資料收集。

但可以肯定的是,這場規模更大的競賽會更好。人工智慧帶來了巨大的隱私風險。它要求創建和收集關於我們和我們的社區的越來越親密、越來越普遍、越來越侵入性的數據。

它是一種將數據進一步集中在少數公司手中的力量,這又是一種不負責任的力量。歷史上很難找到類似的例子。

您批評了英國《線上安全法案》中關於終止端對端加密的規定。您對此以及歐盟的資料規則有何看法?

[英國的線上安全法案]包含了我實際上認為的某種產品或至少部分是這種人工智慧炒作的產品,這是一個非常誤導的條款,暗示人工智慧系統可以以某種方式掃描每個人的個人資訊溝通。

以私密、安全的方式將其與允許表達的資料庫進行匹配,當然還有長期的技術共識。整個專家界都知道這不是真的。

因此我們對此進行了反對,因為作為 Signal,我們依靠端對端加密來為一個充滿監視的世界中真正的私人通訊提供有意義的選擇。因為我們非常關心該法律。

現在,歐洲也制定了類似的法律。看起來他們只是對其進行了調整,以免除掃描網路加密的訊息,這很棒。但當然,三白劇即將到來,並且有一個複雜的政治過程。我們還沒完成。

但我們很高興的是,透過將人權界帶到前台,將真正的技術專業知識而不是人工智慧公司的行銷部門帶到最前沿,我們能夠清楚地表明這是一種神奇的想法,實際上對權利和自由來說是極度危險的。